Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 |

Tags

- GNN

- Python

- elif

- word2vec

- overfitting

- machine learning

- deep learning

- Attention

- Classificaion

- Set Transformer

- sentence embedding

- XOR

- pytorch

- neural net

- Transformer

- abstraction

- sigmoid

- NLP

- python practice

- Self-loop attention

Archives

- Today

- Total

Research Notes

[DL] Neural Network - Dropout and Model Ensemble 본문

▶ Overfitting

- 위 그림처럼 학습 데이터에 모델이 너무 편향된 경우. 학습 데이터는 완벽하게 배웠지만 다른 데이터들에 적용할 경우 성능이 좋지 않디

- Overfitting인지 알 수 있는 방법?

: Training Dataset에서는 거의 100%의 정확도를 내지만, Testing Dataset에서는 성능이 이보다 훨씬 떨어지는 경우.

- Overfitting 문제해결

1) 학습 데이터의 양을 늘리기

2) Regularization : 가중치를 너무 큰 값으로 주지 않도록 하는 것

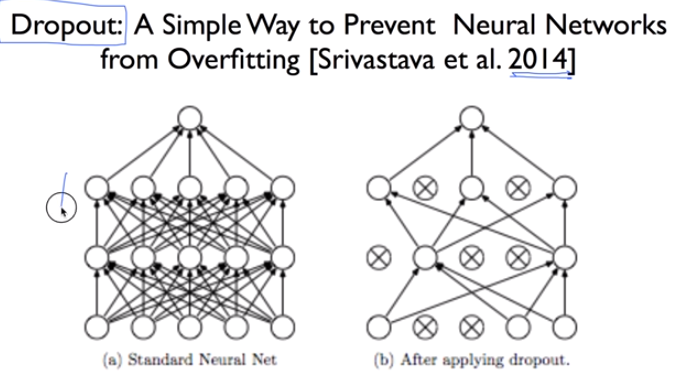

▶ Dropout

- 왼쪽은 기존의 평범한 모델, 오른쪽은 Dropout을 적용한 모델.

- (b)는 모델에서 몇 개의 노드를 없애버리고 나머지 노드들을 사용하여 학습을 시킴.

= 전체를 학습한 효과를 낼 수 있다.

- Dropout은 학습하는 동안에만 시키고, 평가할때나 모델을 사용할 때는 전체 노드를 다 사용해야 한다.

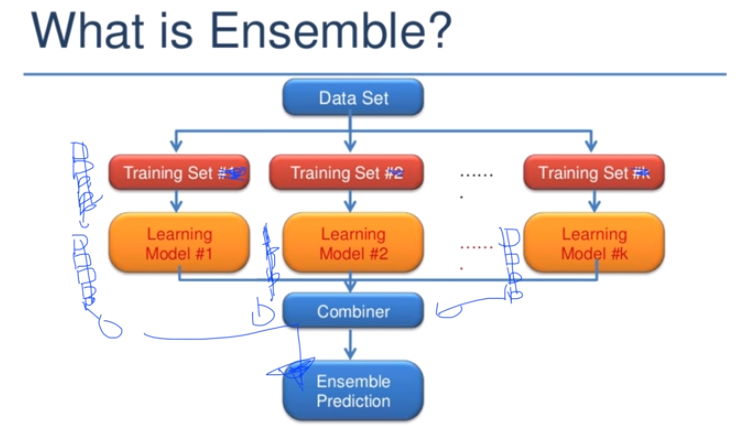

▶ Ensemble(앙상블)

- Idea) 독립된 한 전문가에게 물어보는 것보다 여러 전문가에게 물어보는 것이 더 좋지 않을까?

- 학습 데이터와 모델을 여러개 만들어 이들을 합친 뒤 최종 예측 모델을 만든다.

- 실제로 2~4%정도의 성능 향상에 도움이 됨.

'Study > Deep Learning' 카테고리의 다른 글

| [DL] Recurrent Neural Networks (RNN) (0) | 2023.07.03 |

|---|---|

| [DL] Convolutional Neural Networks (CNN) (0) | 2023.07.03 |

| [DL] Neural Network - ReLU and Weight Initialization (0) | 2023.07.03 |

| [DL] Neural Network - XOR Problem, Back-propagation (0) | 2023.07.03 |

| [DL] Basic Concept of Deep Learning (0) | 2023.07.03 |